С момента создания технологии генеративно-состязательной нейросети (GAN), которая дает возможность создавать дипфейки, прошло уже больше шести лет. Ее в 2014 году разработал студент Стэнфордского университета Ян Гудфеллоу. Система подразумевает реалистичную манипуляцию аудио- и видеоматериалами с помощью искусственного интеллекта. Она заставляет говорить человека то, что он не произносил, и делать то, что он никогда не делал.

За последние годы грань между реальностью и виртуальным миром практически стерлась — тем временем без должного контроля и в неправильных руках технологии превращаются в полную противоположность того, для чего были задуманы, и становятся реальной опасностью. Так произошло и с дипфейками.

Высокореалистичные фейковые фото и видео могут использоваться для дезинформации, мошенничества, кибербуллинга и провокаций. Злоумышленники меняют лицо человека на видео и обвиняют его в правонарушении, шантажируют родственников или влияют на избирателей путем вброса фейковых видео в интернет.

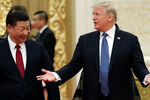

Так, по сети ходил ролик с президентом США Дональдом Трампом, выступающим против климатических инициатив, а также экс-президентом Бараком Обамой, оскорбляющим Трампа.

Самый крупный скандал разразился весной 2019 года, когда в сети появилось видео со спикером палаты представителей США Нэнси Пелоси. Мошенники изменили скорость воспроизведения и голос политика — создалось впечатление, что она пьяна. Только спустя время удалось доказать, что речь Пелоси сгенерировал искусственный интеллект.

Эту технологию также применяют для шантажа. Так, в марте 2019 года у гендиректора британской энергетической компании мошенники смогли выманить €220 тыс. с помощью дипфейковой имитации голоса руководителя головной компании, который якобы потребовал срочно перевести указанную сумму. Все было настолько натуралистично, что мужчина не стал перепроверять информацию — при этом перевод был запрошен на сторонний счет. Деньги бесследно исчезли.

Несмотря на впечатляющие возможности для мошенничеств, исследования показывают, что пока дипфейки используют в основном ради развлечения. Около 96% таких видео в сети — порнографические. К такому выводу пришла компания Deeptrace, которая изучила дипфейк-ролики, опубликованные в июне-июле 2019 года.

Но на самом деле у технологии есть большой потенциал. Ее планируют использовать в астрофизике для избавления фотографий космических объектов от помех и шумов. Год назад компания NVIDIA представила нейросеть, превращающую скетчи в реальные изображения. Ее также можно использовать в архитектуре, дизайне, а также при создании игр и реконструкции исторических событий.

Музей Сальвадора Дали во Флориде «оживил» художника с помощью того же дипфейка. В итоге зрители могли пообщаться с испанским творцом, послушать его истории и даже сделать совместную фотографию. Технология проанализировала 6 тыс. фотографий и 145 видео с Дали, а также массу интервью и писем художника, чтобы воспроизвести его голос, акцент и манеру речи.

Сам по себе алгоритм не «плохой» и не «хороший» ― все зависит от того, в чьих руках он находится. Распространение ложной информации, вторжение в частную жизнь, разрушение репутации — это только небольшая часть того, к чему могут привести дипфейки. IT-гиганты, такие как Facebook, Microsoft, Google, пытаются бороться с распространением таких видео. Они учат алгоритмы выявлять дипфейки. В FB даже анонсировали конкурс с призовым фондом в $10 млн на лучшую разработку.

«Сами соцсети выработали алгоритмы по защите пользователей от дипфейков. Они ввели маркировки, а также механизмы блокировки такого контента. Но, во-первых, не все соцсети такие алгоритмы используют, а, во-вторых, они не совершенны. Российским законодателям нужно установить минимальное количество правил для соцсетей, а механизмы реализации отдать на откуп соцсетям. С этой проблемой можно бороться только технологически.

Задача государства — создать нормативную базу, которая бы смогла обеспечить баланс для развития технологий и защиты личности», — сообщил «Газете.Ru» председатель комиссии по правовому обеспечению цифровой экономики московского отделения АЮР Александр Журавлев.

В США и вовсе считают дипфейки угрозой национальной безопасности страны. Законодатели обеспокоены тем, как эта технология повлияет на будущую предвыборную кампанию и политическую обстановку в целом.

Калифорния стала первым штатом, где на законодательном уровне запретили распространение дипфейков с кандидатами во время предвыборной гонки. Кроме того, законопроект AB-602 запретил использование технологий синтеза изображений человека для изготовления порнографического контента без согласия изображаемых.

В России также уделяется особое внимание созданию безопасной цифровой среды и системе ее комплексного правового регулирования. Важность этого в сентябре отмечал президент России Владимир Путин на 75-й сессии ГА ООН.

«Помимо национального законодательства, важно работать на международном уровне. Об этом говорил президент на последней конференции ООН. Одним из ярких примеров движения в эту сторону стало заключение меморандума между Ватиканом, а также компаниями Microsoft и IBM об основах работы с искусственным интеллектом. Были прописаны требования по тому, как работать с этой технологией и сколько давать ей свободы. Нужно дальше двигаться в этом направлении — заключать аналогичные соглашения с другими странами. Эта деятельность трансгранична — если в России будут законодательные ограничения, а в Испании или Черногории нет, то злоумышленники будут пользоваться отсутствием соответствующей правовой базы и распространять запрещенный контент через другие каналы.

В этом случае борьба с дипфейками на территории России нивелируется. Нужно работать в коалиции, чтобы злоумышленники не достигали своих целей», — считает Журавлев.

Кроме того, он напомнил, что сейчас в России нет инструментов, позволяющих защитить граждан от дипфейков.

«С одной стороны, у нас есть статья 152.1 ГК РФ, которая охраняет изображение любого гражданина. Оно может быть использовано только с его согласия. Если же человек хочет привлечь к ответственности авторы дипфейка, то возникает вопрос: к кому подавать иск? Можно обратиться к самой платформе, распространившей контент, и попросить удалить его. Но пока человек пройдет все процедуры, видео увидят все. За это время может испортиться его репутация», — подчеркивает член АЮР.

С ним согласен учредитель АНО «ПравоРоботов», член экспертного совета по цифровой экономике при Госдуме Никита Куликов. Однако он отмечает, что на данный момент дипфейки выглядят «достаточно грубоватыми», чтобы спутать их с реальностью.

«Однако все равно найдутся те, кто поверит. Чем больше информации будет у искусственного интеллекта, тем скорее будут стерты все видимые грани и различия. Нужно учить программы четко выявлять дипфейки. Но где найти мощности для создания таких технологий, это вопрос. Кроме того, важно повышать в России цифровую грамотность – это на 50% залог того, что дипфейки не будут влиять на жизнь граждан. Больше всего подвержены влиянию таких технологий граждане старшего возраста – с ними и нужно плотно работать», — сообщил эксперт в разговоре с «Газетой.Ru».

Цивилизация

Цивилизация